자주 사용하는 도커 명령어를 정리해 보려고 한다. gpu 리눅스(우분투) 서버를 사용하게되면서 도커의 필요성이 느껴져서 공부를 하게 되었는데 명령어를 자꾸 까먹어서 자주쓰는 명령어들을 블로그에 정리하려고 한다. 기본 명령어 1. 현재 보유중인 도커 이미지 확인 sudo docker images 2. 현재 작동중인 도커 컨테이너 확인 sudo docker ps 3. 모든 도커 컨테이너 확인 sudo docker ps -a 4. 도커 이미지 삭제 sudo docker rmi [이미지ID] 이미지를 삭제하기 위해서는 컨테이너가 삭제 되어야 함 5. 도커 컨테이너 삭제 sudo docker rm [컨테이너ID] 컨테이너가 삭제되기 위해서는 컨테이너가 중지되어야 함 6. 도커 컨테이너 중지/재시작 sudo doc..

이번 포스팅에서는 현재 kaggle에서 진행중인 classification competetion중 [SETI Breakthrough Listen - E.T. Signal Search] 데이터를 이전 포스팅에서 다룬 Swin transformer와 블로그에서 처음 소개하는 Weights and bias tool을 활용해서 학습해보려고 한다. E.T. Signal Search? 이 데이터셋은 한마디로 정리하자면 시그널중에서 외계신호 즉 이상치를 탐지하는 것이다. 단지 시계열데이터가 아닌 이미지 데이터로 주어지고 그것이 비정상 즉 외계신호라면 1 아니라면 0을 예측해야하는 Binary Classification 문제이다. Install accelerate & wandb !pip install -q accele..

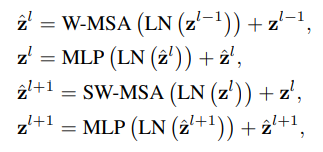

Swin Transformer: Hierarchical Vision Transformer using Shifted Windows Ze Liu† / Yutong Lin† / Yue Cao / Han Hu / Yixuan Wei† / Zheng Zhang / Stephen Lin / Baining Guo / Microsoft Research Asia 이번 포스팅에서는 2021년 3월에 마이크로소프트(아시아)에서 발표한 Swin Transformer에 대해 알아보려고 한다. 해당 논문은 ViT에서 모든 patch가 self attention을 하는 것에 대한 computation cost를 지적하면서 각 patch를 window로 나누어 해당 윈도우 안에서만 self attention을 수행하고 그 윈도우를 ..

이번 포스팅에서는 PyTorch Ligtning에 대해 알아보려고 한다. https://www.pytorchlightning.ai/ PyTorch Lightning The ultimate PyTorch research framework. Scale your models, without the boilerplate. www.pytorchlightning.ai PyTorch Lightning이란 또다른 딥러닝 프레임워크가 아닌 PyTorch 문법을 가지면서 학습 코드를 PyTorch보다 더 효율적으로 작성할 수 있는 파이썬 오픈소스 라이브러리이다. PyTorch를 통해 쉽게 딥러닝 모델을 만들 수 있지만 CPU, GPU, TPU간의 변경, mixed_precision training(16 bit)등의 복잡한..

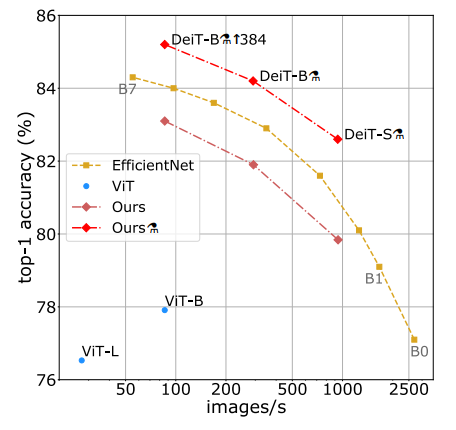

Training data-efficient image transformers & distillation through attention Hugo Touvron / Matthieu Cord / Matthijs Douze / Francisco Massa / Alexandre Sablayrolles / Herve Jegou Facebook AI and Sorbonne University 이번 포스팅에서는 2020년 12월에 Facebook AI에서 발표한 DeiT라는 논문에 대해 리뷰하려고 한다. 이 논문에서는 Vision Transformer(ViT)가 당시 SOTA를 달성했지만 JFT-300M 데이터셋을 pretrain에서 쓰고 ImageNet으로 finetuning을 하면서 엄청나게 많은 데이터셋을 사용..

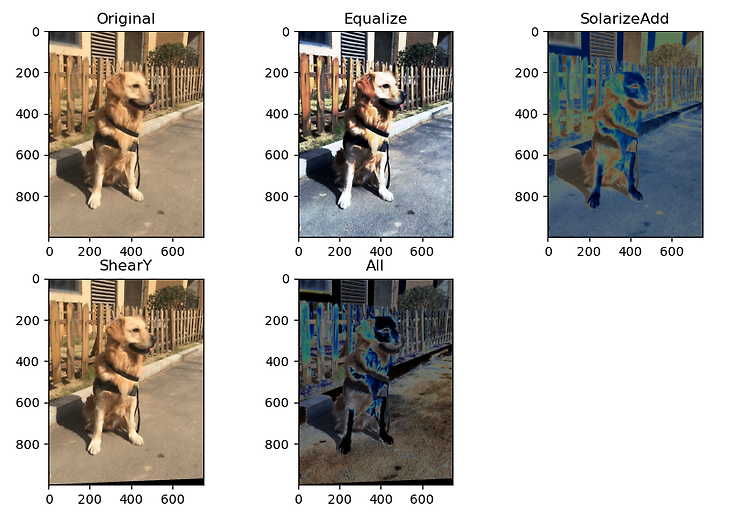

RandAugment: Practical automated data augmentation with a reduced search space Ekin D. Cubuk ∗ , Barret Zoph∗ , Jonathon Shlens, Quoc V. Le Google Research, Brain Team 이번 포스팅에서는 google brain에서 2019년 10월에 발표한 RandAugment라는 논문에 대해 알아보려고 한다. 이 논문의 중점은 기존의 Auto Augmentation의 search space보다 훨씬 낮은 space로 비슷한 성능을 낼 수 있다는 것이다. What is RandAugment? data augmentation은 딥러닝 모델을 일반화시키는데에 도음을 주는 중요한 작업이다. 하지만..